boosting集成原理:什么是boosting?

更新时间:2021年04月30日15时19分 来源:传智教育 浏览次数:

什么是boosting?

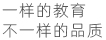

随着学习的积累从弱到强,简而言之:每新加入一个弱学习器,整体能力就会得到提升。代表算法:Adaboost,GBDT,XGBoost。

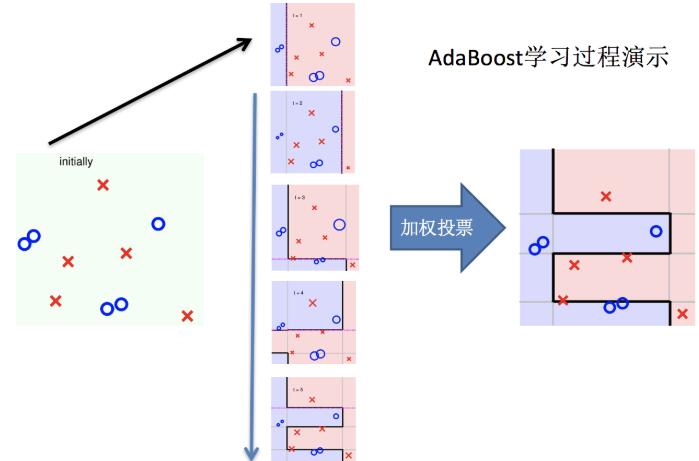

实现过程

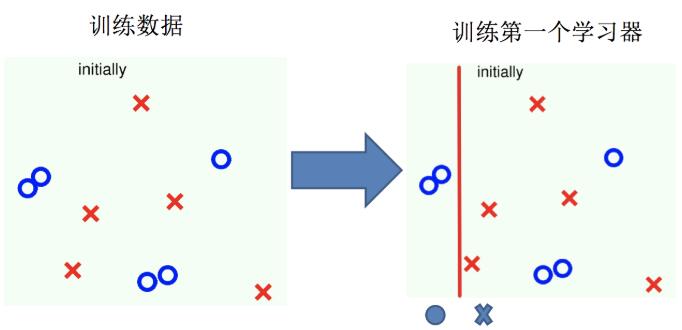

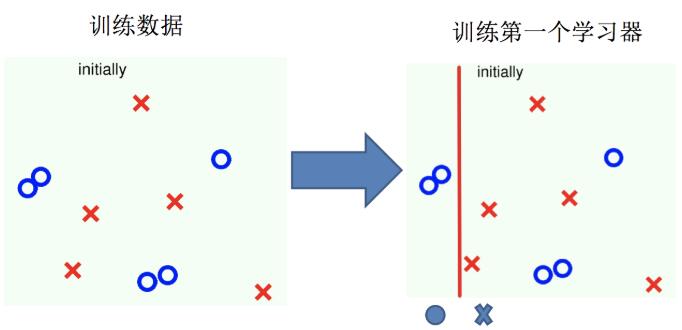

(1)训练第一个学习器

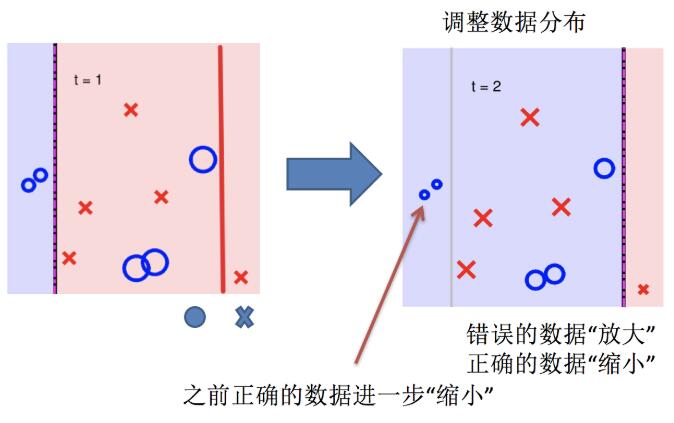

(2)调整数据分布

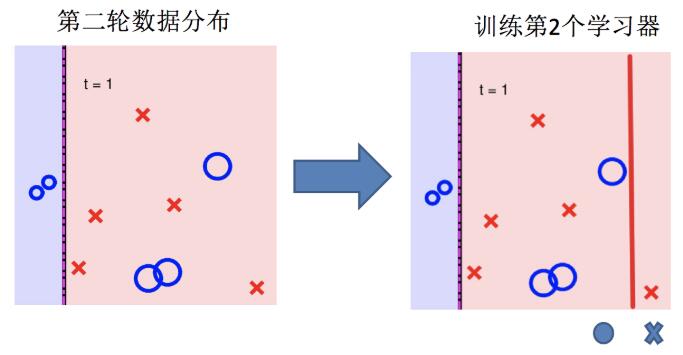

(3)训练第二个学习器

(4)再次调整数据分布

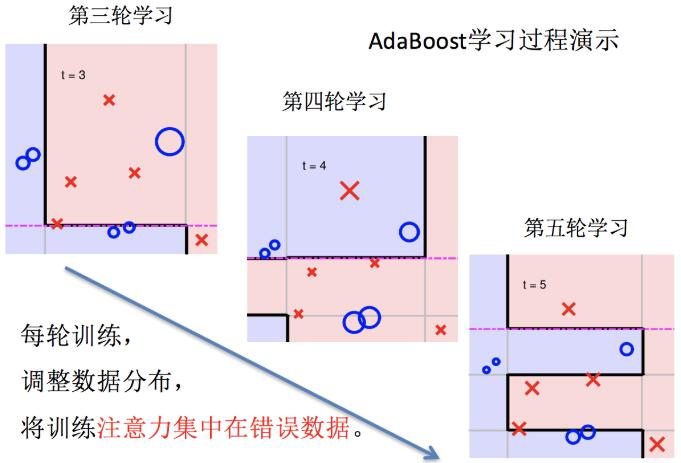

(5)依次训练学习器,调整数据分布

(6)整体过程实现

关键点:

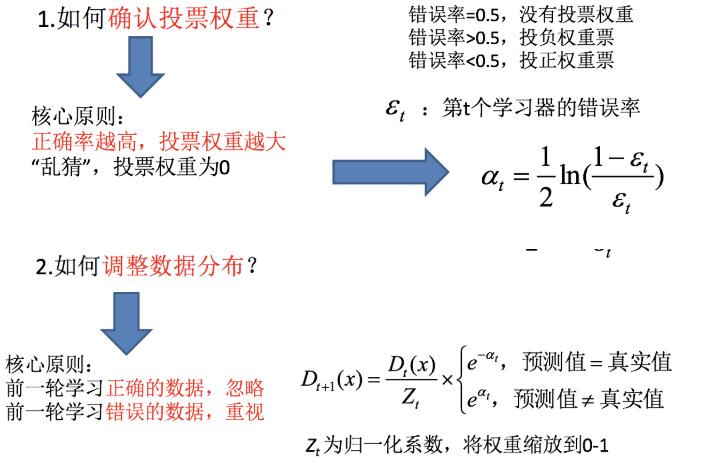

如何确认投票权重?

如何调整数据分布?

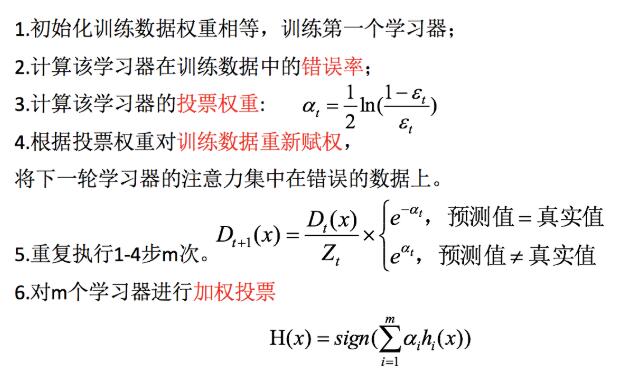

AdaBoost的构造过程小结

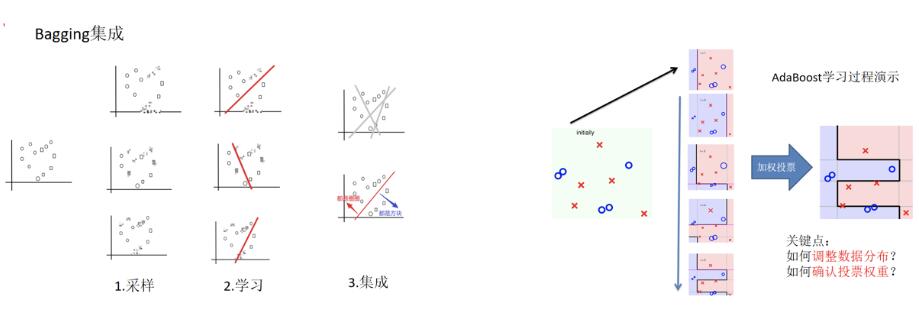

bagging集成与boosting集成的区别:

区别一:数据方面

Bagging:对数据进行采样训练;

Boosting:根据前一轮学习结果调整数据的重要性。

区别二:投票方面

Bagging:所有学习器平权投票;

Boosting:对学习器进行加权投票。

区别三:学习顺序

Bagging的学习是并行的,每个学习器没有依赖关系;

Boosting学习是串行,学习有先后顺序。

区别四:主要作用

Bagging主要用于提高泛化性能(解决过拟合,也可以说降低方差)

Boosting主要用于提高训练精度 (解决欠拟合,也可以说降低偏差)

猜你喜欢:

AI智能应用开发

AI智能应用开发 鸿蒙应用开发

鸿蒙应用开发 HTML&JS+前端

HTML&JS+前端 Python+大数据开发

Python+大数据开发 人工智能开发

人工智能开发 跨境电商

跨境电商 电商视觉设计

电商视觉设计 软件测试

软件测试 新媒体+短视频

新媒体+短视频 集成电路应用开发

集成电路应用开发 C/C++

C/C++ 狂野架构师

狂野架构师 IP短视频

IP短视频